Вы ни когда не размышляли как работает поисковая система рунета? Что движет этим монстром и как происходит весь процесс индексации вашего сайта? А я решил с этим разобраться чтобы на будущее знать, чего бояться, чего нет. Поисковый робот («веб-паук», паук, спайдер, краулер), он является составной частью поисковой системы и предназначен для обхода страниц Интернета с целью занесения информации о них (ключевые слова) в базу данных.

Вы ни когда не размышляли как работает поисковая система рунета? Что движет этим монстром и как происходит весь процесс индексации вашего сайта? А я решил с этим разобраться чтобы на будущее знать, чего бояться, чего нет. Поисковый робот («веб-паук», паук, спайдер, краулер), он является составной частью поисковой системы и предназначен для обхода страниц Интернета с целью занесения информации о них (ключевые слова) в базу данных.

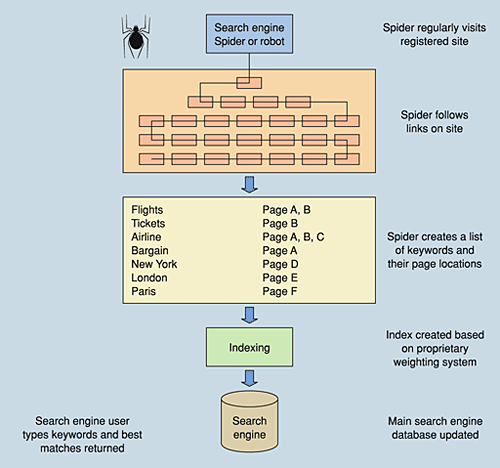

Принцип работы роботов сканировать содержимое страницы и забрасывать ее на сервер поисковой машины. Сам из себя паук представляет обычный браузер. На рисунке ниже показан весь алгоритм работы робота.

Ну как известно всему человечеству, роботы это всего лишь машина и значит ими можно управлять. Для этого вам нужно создать инструкцию для робота в файле robots.txt, и прописать что индексировать а что нет. При этом заметим, что доступ на эти страницы, если на них есть входящие ссылки, для робота будут открыты, только он не заносит их в индекс.

Более подробно хочу остановиться на файле robots.txt так как все поисковые роботы при заходе на сайт в первую очередь ищут именно этот файл. Если вы используете готовые движки CMS , в них уже настроен файл robots.txt , единственное вы можете в ручную прописать что именно скрыть от индексации.

Ну а если вы создаете свой сайт с нуля, без посторонних скриптов, тогда создаем обычный текстовый файл и называем его robots.txt (разместите его в корне сайта), если вы не собираетесь создавать запреты к индексации, можно сделать пустой файл. Инструкция создания файла robots.txt здесь.

Поисковые системы бывают 2 видов:

- Основной сканирующий робот

- Быстрый робот, который регулярно сканирует сайты, на которых информация обновляется и вносит информацию с этих сайтов в поисковую систему, что обеспечивает быстрое обновление индекса поисковой системы.

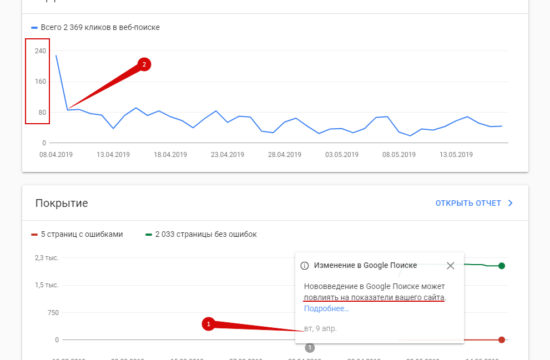

Обновление поисковой базы происходит пару раз в месяц. В поиске начинают выдаваться обновлённые страницы сайтов, собранные

основным сканирующим роботом. Таким образом работают поисковые системы рунета. Здесь можно написать целую книгу по работе с ней, перечислить все поисковики, кто как работает и как быть на первой странице в поисковой системе. Ну писать книгу я не собираюсь, на эту тему я уделю еще не один пост, так что будьте на связи…)